서 언

재료 및 방법

실험 재료 및 재배 환경 조건

이미지 데이터 수집

합성곱 신경망(CNN)

티처블 머신(Teachable Machine)

결과 및 고찰

합성곱 신경망(CNN)

티처블 머신(Teachable Machine)

서 언

작물의 재배관리를 위해 생장의 상태를 실시간으로 측정하는 것은 매우 중요하다. 완전제어형 식물공장에서는 정밀한 환경조절을 통해 재배 작물의 균일한 성장을 유도하기 때문에 정식 후 일수를 생장의 지표로 활용 할 수 있다(Cha et al., 2014). 작물을 재배하는 과정에서 이미지 데이터는 실시간으로 측정할 수 있는 데이터이다. 그렇기에 이미지 데이터를 통해 정식 후 일수를 실시간으로 예측하는 모델은 작물 생장의 상태를 실시간으로 파악하는 데 이용할 수 있다.

최근 다양한 분야에 인공지능이 도입되고 있는 추세이다. 인공지능은 컴퓨터 공학뿐만 아니라 생물학과 의학 분야에도 적용되고 있으며 농업 분야에 도입하려는 연구도 전세계적으로 활발하다. 현재 인공신경망(artificial neural network, ANN)을 이용한 인공지능은 머신러닝, 딥러닝, 전이학습 등 다양한 메커니즘으로 사용되고 있다. 그 중 딥러닝이나 전이학습은 이미 빅데이터가 준비되어 있는 상태에서 충분한 모델링이 이루어진 후에 활용될 수 있는데 아직 데이터가 부족한 현장에서는 활용하기 어려운 단점을 갖는다. 그러나 규격화되고 정제된 데이터를 통해서는 보다 적은 데이터로도 유의미한 결과를 이끌어 낼 수 있다(Choi, 2018). 노지에서의 작물 재배는 광이나 온도 같은 지상부 환경이나 토양내 수분함량 같은 지하부 환경 조건이 일정하지 않고 이에 따른 작물의 생육도 일정하지 않아 일정기간동안의 균일한 작물 이미지 데이터를 확보하기 어렵다. 그에 반해 식물공장은 미세한 환경 조절이 가능하여 작물의 생육이 균일하기 때문에 규격화된 데이터를 생산하기에 적합하다.

인공신경망의 구조 중 이미지의 공간적/지역적 정보를 이용해 특성을 추출하는 이미지 분류에 관하여 합성곱 신경망(convolutional neural network, CNN)의 개념이 최초로 제시(LeCun and Bengio, 1995)된 이래 이를 사용하여 일반적인 이미지 분류(Rawat and Wang, 2017) 분야에서 널리 쓰이고 있으며, 의학분야(Anwar et al., 2018)와 조직병리학(Kate and Shukla, 2021) 분야 등에서도 합성곱 신경망을 사용하고 있다. 농업에서도 토마토의 영양성분과 이미지의 관계(Tran et al., 2019), 허브의 생육 예측(Hao et al., 2020), 파프리카의 작물 생체중(Moon et al., 2020), 엽면적지수(Lee et al., 2020)와 증발산량 추정(Nam et al., 2019) 등에 사용되었다. 또한 노지 상추의 생육을 예측하기 위한 연구(Iitsuka et al., 2019)도 이루어진 바 있다.

인공지능에는 다양한 툴들이 이용되고 있는데 파이썬(Python)의 라이브러리인 텐서플로(Tensorflow)가 널리 활용되고 있다. 본 실험에서는 식물공장에서 재배한 상추의 이미지 데이터를 이용하여 파이썬의 텐서플로를 통해 합성곱 신경망(CNN)을 구성하여 정식 후 일수 예측을 위한 인공지능 모델을 생성해보고자 한다. 이를 통해 식물공장에서 정식 후 일수를 예측하고 재배작물의 생장수준을 실시간, 비파괴적으로 파악할 수 있다. 또한, 예상치보다 생장이 늦는 경우에는 재배환경의 문제, 생리장애의 문제, 또는 병충해 등이 있을 수 있다는 시그널로써 활용될 수 있기 때문에 정확한 정식 후 일수를 예측하는 것은 작물 재배 관리 측면에서 유용하다. Teachable Machine(http://teachablemachine.withgoogle.com)은 텐서플로를 개발한 구글(Google)사에서 제공하는 머신러닝 분류 모델을 만들기 위한 웹기반 GUI툴이다. 프로그래밍에 대한 전문적 이해가 부족하더라도 쉽게 머신러닝을 사용할 수 있게 해주는 툴로서 특히 이미지 분류에 사용하기 용이하여 이미지를 통한 인공지능 연구에서 종종 사용되고 있다(Lee and Kacorri, 2019; Carney et al., 2020).

본 연구는 완전제어형 식물공장 시스템에서 규격화된 이미지 데이터를 수집하고, 텐서플로를 통한 합성곱 신경망과 구글의 티처블 머신을 통해 상추의 정식 후 일수를 예측하는 인공지능 모델을 생성하여 식물공장에서 이미지를 통해 실시간, 비파괴적으로 상추의 생육상태를 파악하기 위해 수행되었다.

재료 및 방법

실험 재료 및 재배 환경 조건

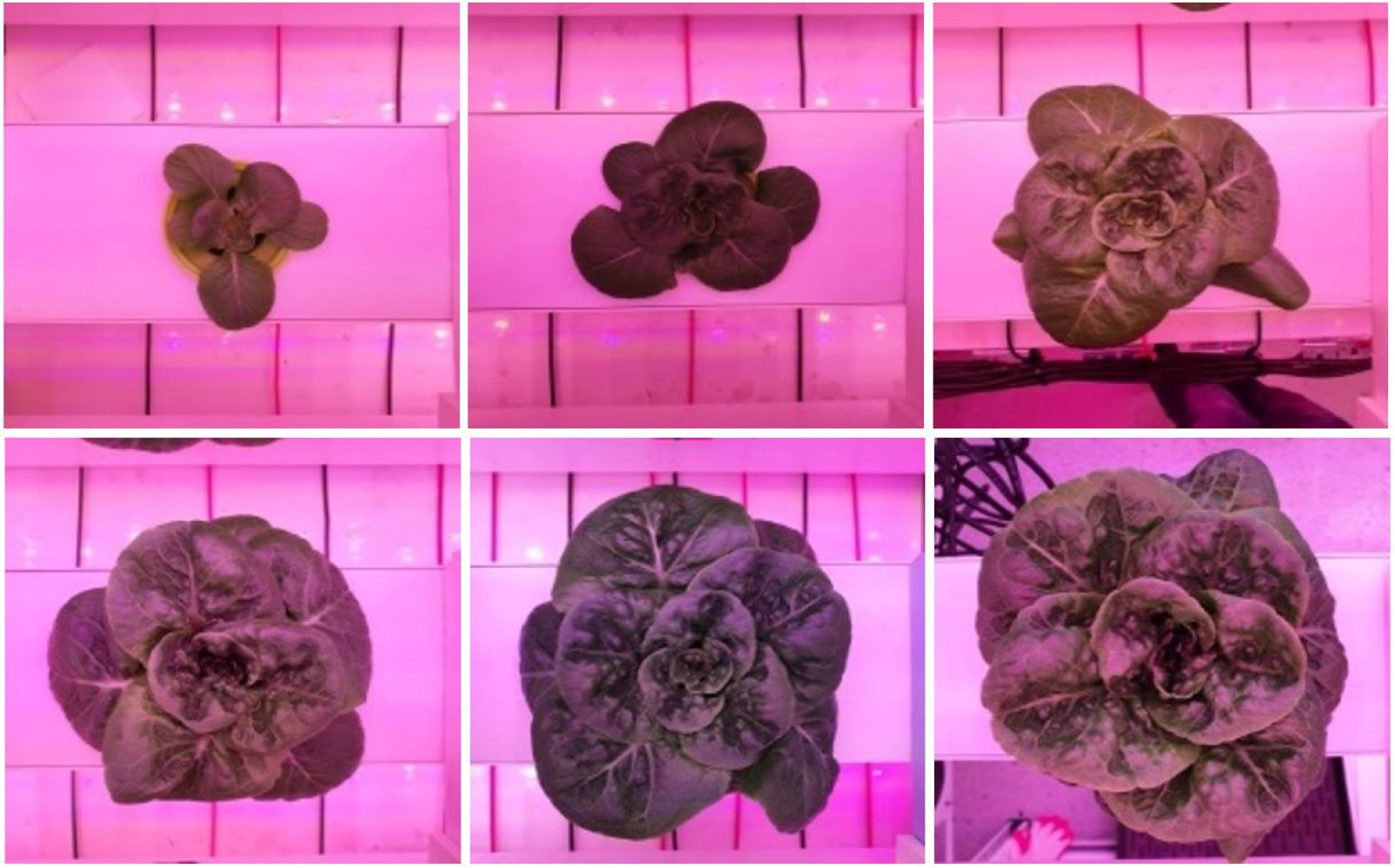

본 연구에서는 동일한 환경의 식물공장에서 수행한 3번의 재배실험을 통해 상추의 정식 후 일자(days after transplanting, DAT)별 이미지 데이터를 확보하였다(Fig. 1). 실험에 사용된 재배시스템은 NFT 시스템 [240 × 60 × 200cm(L × W × H)]이었으며 실험에 사용된 품종은 청상추 ‘Thimble’(Lactuca sativa L. cv. ‘Thimble’, Nunhems B.V., The Netherlands)이었다. LED 조명 RGB의 비율은 8:1:1로 세팅하였고 12시간 일장으로 광량은 265(±50) µmol·m-2·s-1로 조절하였다. 양액은 호글랜드 용액(Hoagland and Arnon, 1950)으로 pH 5.5–6.5, EC 1.0dS·m-1로 관리하였다. 재배 환경은 온도 19–21°C, 상대습도 55–65%로 조절하였으며, CO2 500–800µmol·mol-1였다. 환경 데이터는 온습도 센서(HMP60, Vaisala, Finland)와 CO2 센서(GMP252, Vaisala, Finland)를 사용하여 측정하였고, 측정한 데이터는 데이터수집장치(CR-1000, Campbell Science, Logan UT, USA)를 이용하여 매분, 매시간의 평균값을 수집하였다. 3번의 실험은 모두 동일하게 ‘Thimble’ 종자를 우레탄 스폰지(2.5 × 2.5 × 2.5cm)에 파종하여 3주간 육묘한 후, 실험구를 완전임의배치법으로 배치하여 재식거리 20 × 20cm (25plants/m2)로 정식한 후 재배하였다.

이미지 데이터 수집

동일한 환경에서 수행한 3번의 실험을 통해 총 12개체의 ‘Thimble’에서 정식 후 일수에 따른 이미지를 촬영하였고, 이 과정에서 3번의 실험 모두에서 동일한 이미지 규격을 통한 학습을 위해 27 × 20 × 25cm(L × W × H) 상자를 만들어 촬영에 사용하였다.

모든 실험에서 중복으로 데이터를 확보한 날짜인 정식 후 4일(4 DAT), 8일(8 DAT), 12일(12 DAT), 15일(15 DAT), 18일(18 DAT), 22일차(22 DAT) 총 6번의 생육 일수에 대하여 총 288장의 이미지 데이터를 수집하였으며, 그 중 10개체의 240장의 이미지 데이터를 인공지능 학습용으로 사용하였다. 학습에 사용하지 않은 2개체의 48장의 이미지 데이터는 생성된 인공지능 모델에 대한 검정에 사용하였다.

합성곱 신경망(CNN)

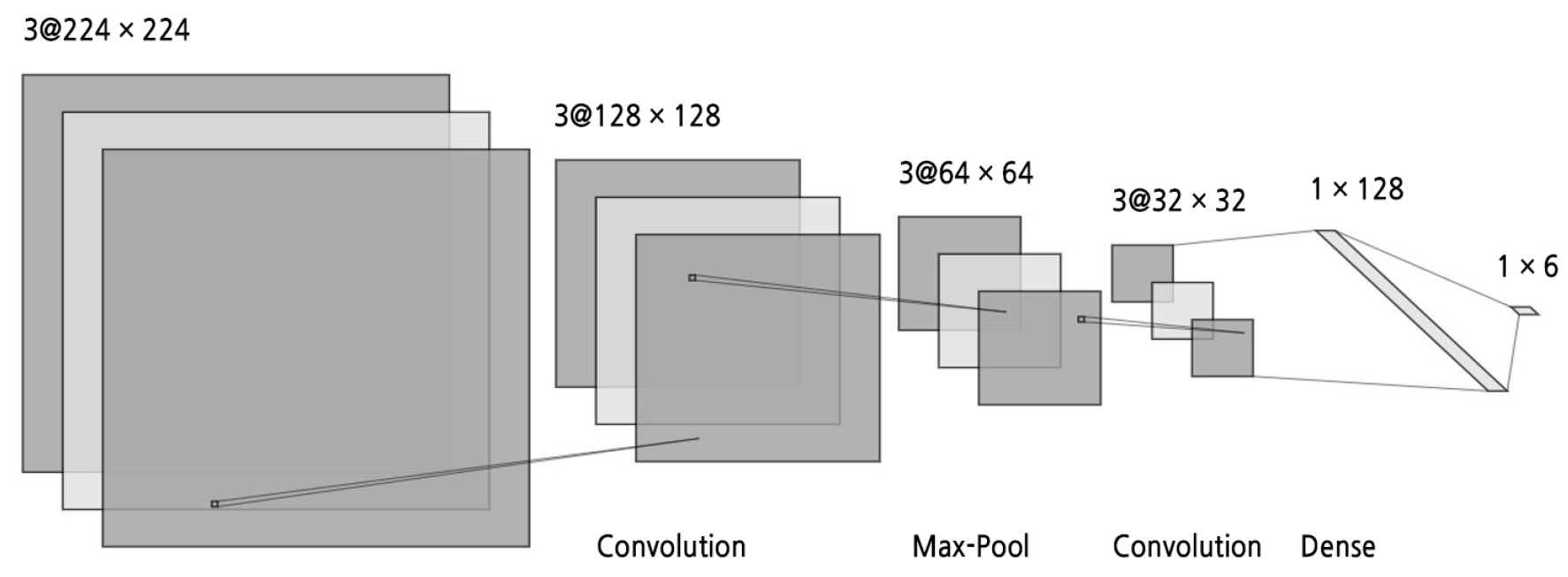

이미지를 통한 분류모델에서 널리 사용하는 합성곱 신경망(CNN)은 이미지의 각 픽셀을 본래 픽셀과 그 주변 픽셀의 조합으로 필터 행렬의 합성곱을 이용해서 네트워크가 특징을 추출해낼 수 있게 된다. 수용영역(Receptive field)이라고도 부르는 합성곱하는 필터 행렬의 사이즈(Kernel size)는 일반적인(3,3)행렬을 사용하였다. 은닉층(Hidden layer)을 다양하게 변화시켜본 결과 Fig. 2와 같은 구조의 총 파라메터가 280만여개로 구성된 합성곱 신경망(CNN)구조를 만들어 학습에 사용하였다. 활성화함수로는 Rectified Linear Unit(ReLU)함수를 사용하였다. ReLU함수는 신경망 초기에 사용하던 sigmoid함수에서 데이터 학습과정에서 활성화함수를 통해 계속 미분을 진행해 나가면 처리된 값이 지속적으로 작아지게 하는 문제가 발생하기에 이를 해결하고자 제시한 함수이다(Nair and Hinton, 2010). 특히 은닉층이 심도가 깊어지는 딥러닝으로 발전하면서 그 오류가 더 심각해지기 때문에 ReLU함수가 널리 쓰이고 있다. 최적화 방식으로는 2014년 발표되어 인공신경망 최적화의 우수성을 인정받은 Adam optimizer를 사용하였다(Kingma and Ba, 2014).

학습에 사용한 240장의 이미지 데이터는 수집한 정식 후 일수에 따라 4 DAT, 8 DAT, 12 DAT, 15 DAT, 18 DAT, 22 DAT 이렇게 6개의 클래스로 나누었으며 이미지 데이터는 전처리를 통해 224 × 224의 해상도, RGB 3채널의 데이터로 변환시켰다. 이는 추후 살펴볼 티처블 머신에서와 같은 기준이다. 학습의 효율을 증가시키기 위하여 정규화(Normalization)를 통해 데이터 값의 범위를 0–1사이의 값으로 변환시켰다. 전처리된 데이터를 Fig. 2의 구조를 기본으로 한 합성곱 신경망에 학습시켜 인공지능 모델을 생성하였다.

학습된 인공지능 모델의 정확도를 확인하기 위해 학습에 사용되지 않은 48장의 이미지 데이터를 검정에 사용하여 생성된 인공지능 모델의 검정 정확도(Validation accuracy)를 확인하였다.

티처블 머신(Teachable Machine)

코딩과 인공지능에 익숙하지 않은 연구자들도 간단한 GUI를 통해 초기모델로서 가능성을 알아보고자 할 때 조금 더 쉽고 빠르게 접근할 수 있는 방법을 알아보기 위해 티처블 머신(Teachable Machine)을 통해서도 인공지능 모델을 생성해보았다.

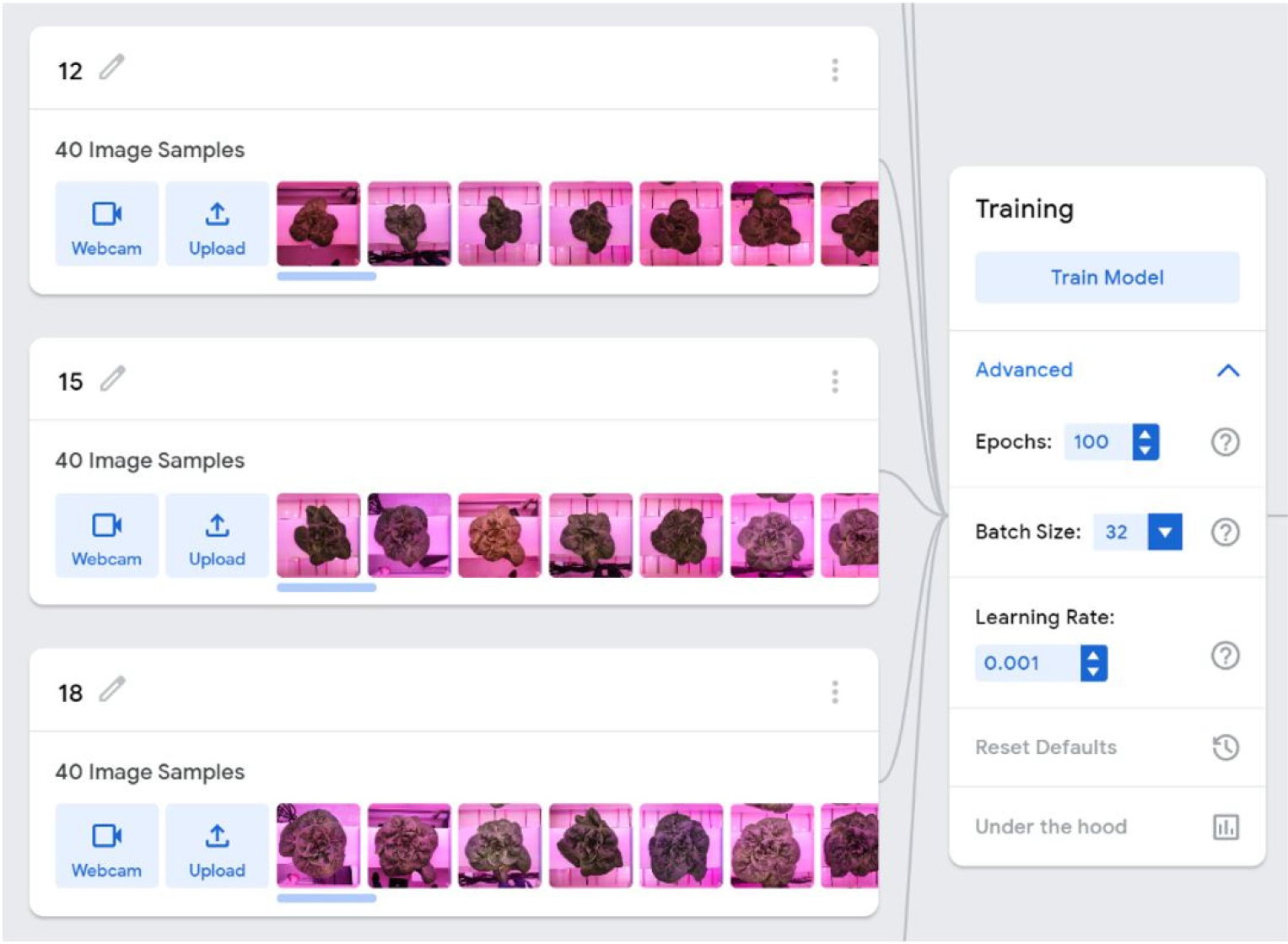

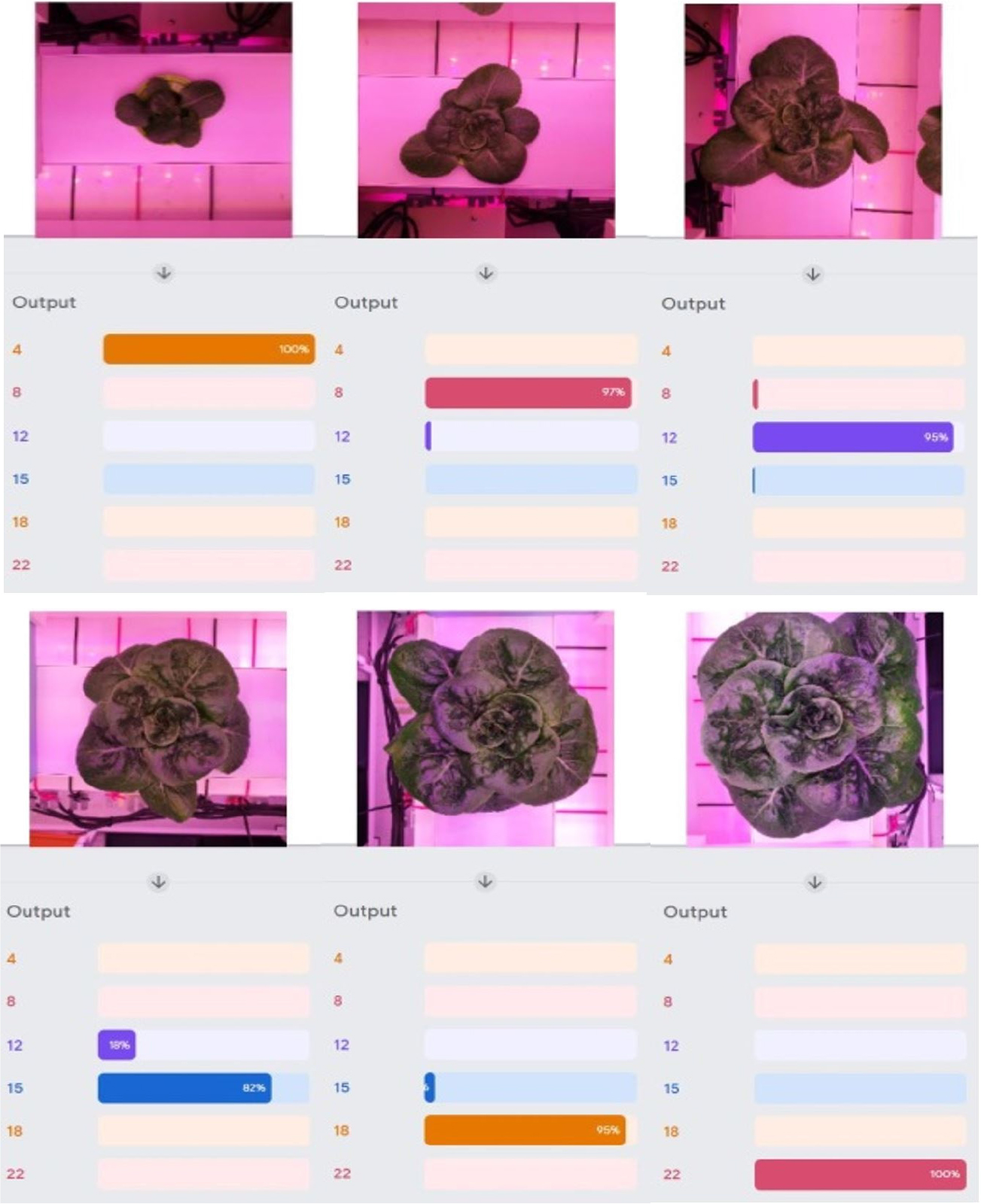

이번에도 합성곱 신경망에서와 마찬가지로, 모든 실험에서 중복으로 데이터를 확보한 날짜인 정식 후 4일, 8일, 12일, 15일, 18일, 22일차 6번의 DAT별 이미지 데이터, 총 280개 중 10개체의 240개 이미지 데이터를 일자별 40장씩 구글의 티처블 머신을 통해 Fig. 3과 같이 머신 러닝 학습시켜 인공지능 모델을 생성하였고 학습에 사용되지 않은 2개체의 48개 이미지를 검정에 사용하였다.

티처블 머신의 특성으로 인해 이미지데이터를 머신러닝 시켜 인공지능 모델을 생성할 때 약간씩 다른 결과의 인공지능 모델이 생성되었다. 이는 보통 텐서플로를 통해 합성곱 신경망 등의 인공 신경망을 사용할 때 재현성을 구현하기 위해 코드상에 난수 생성기의 인수를 하나로 고정시켜 놓기도 하는데 반하여 티처블 머신에서는 난수가 변경되기 때문인 것으로 보인다.

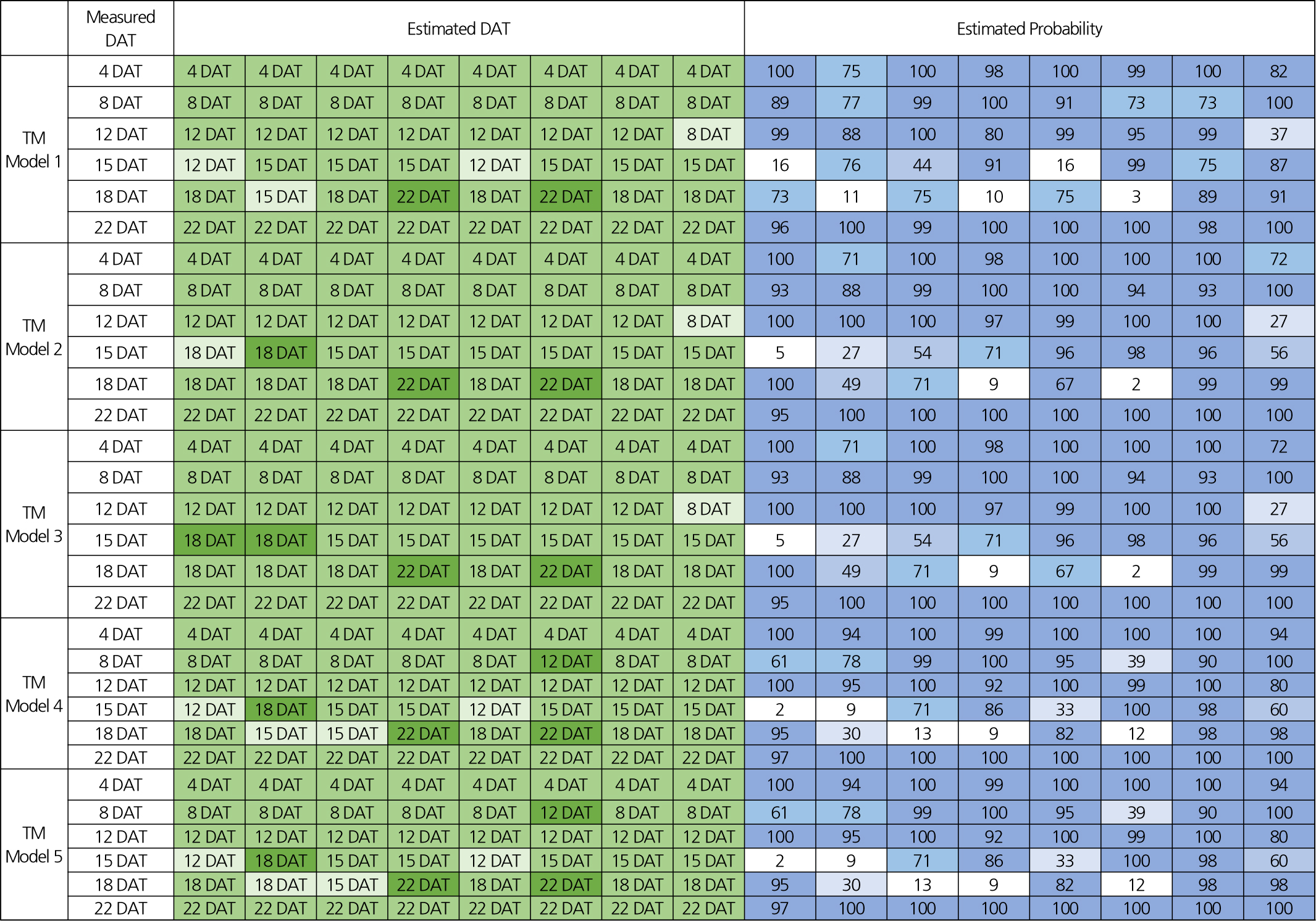

때문에 통계적인 유의성을 보기 위하여 티처블 머신 모델(TM Model)을 5번 반복적으로 생성하였으며, 각각의 경우를 모두 검정하여 전체적인 정확도를 계산하였다. 따라서 총 5개의 모델에서 각각 48개의 이미지를 통해 정식 후 일수 예측확률을 검정하여 총 240번의 검정을 실행하였고 이를 Fig. 5에 표시하였다.

결과 및 고찰

합성곱 신경망(CNN)

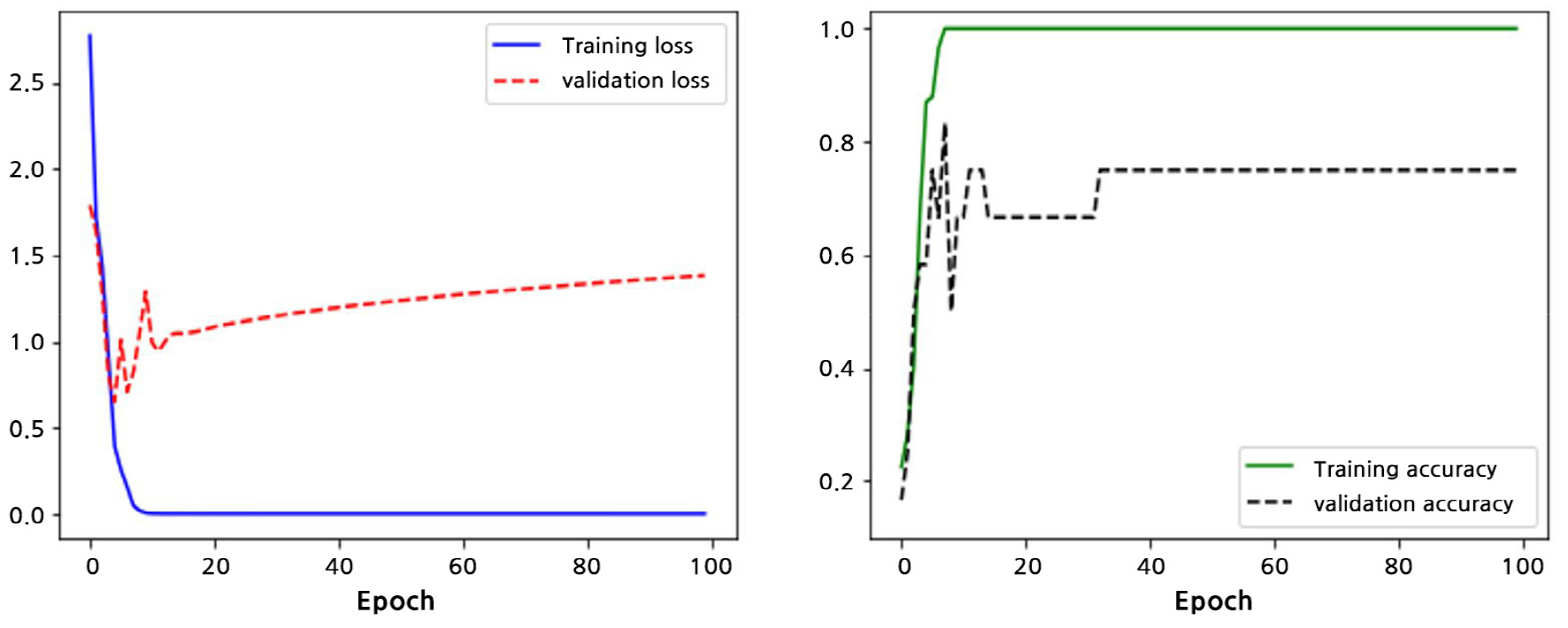

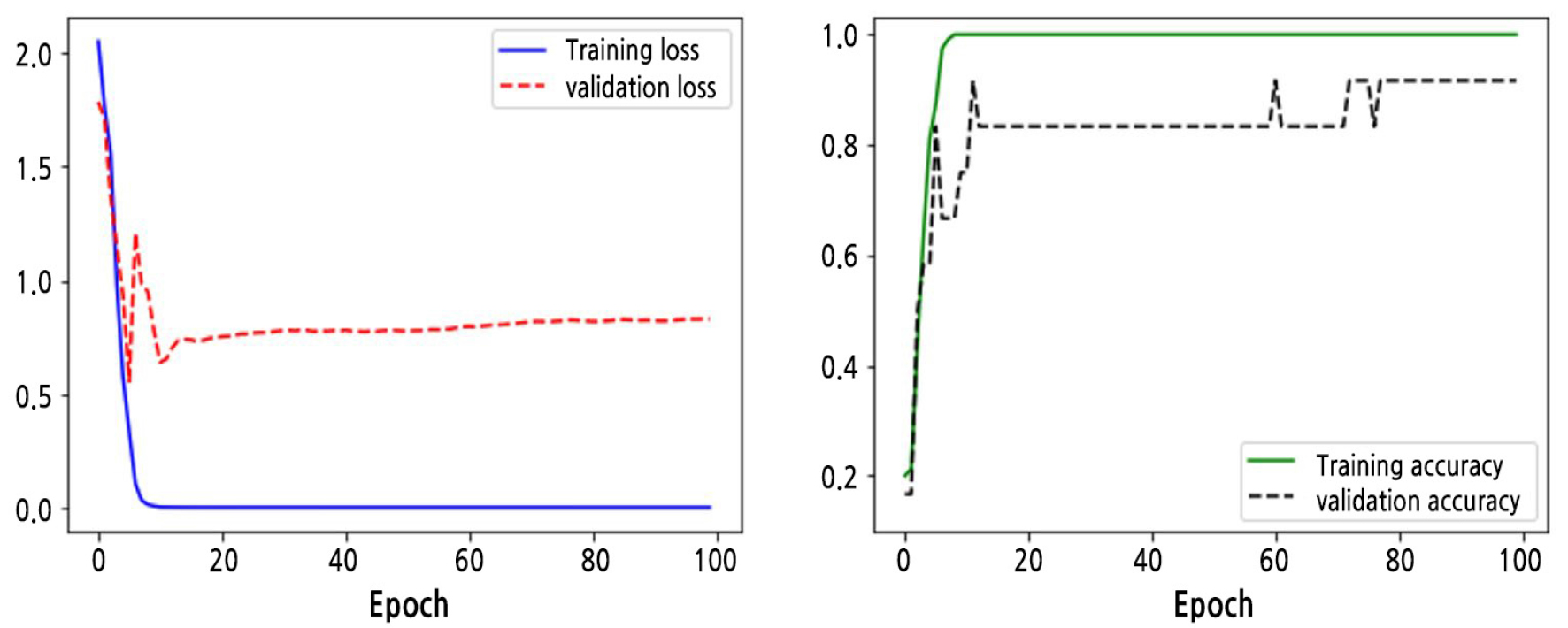

인공신경망에서 은닉층을 최적화시키기 위해 은닉층의 구조와 배치 사이즈(batch size) 그리고 에포크(Epoch)를 다양하게 조정하여 테스트해 본 결과를 바탕으로 최종적으로 배치 사이즈(batch size)는 32, 에포크는 100회의 설정(Table 1)으로 합성곱 신경망을 통해 정식 후 일수에 따른 이미지 데이터를 학습시켜 본 결과 Fig. 5와 같은 결과를 확인할 수 있었다. 로우 데이터(Raw data)의 양이 적었기 때문에 학습 데이터(Training data)의 학습률은 빠르게 1에 도달하였으며 40회 정도의 에포크에서 검정 정확도가 75%에 도달하였다.

Fig. 4에서 검정 손실(Validation loss)를 살펴보면 학습 손실(Training loss)에 비해 지속적으로 증가하고 있는 전형적인 과적합(Overfitting)되고 있는 모습을 살펴볼 수 있었다. 과적합이란 인공지능 모델을 학습 데이터에만 과도하게 맞추려 하기 때문에 오히려 학습에 사용하지 않은 검정 데이터에서는 오차가 커지게 되는 현상이다. 때문에 네트워크의 과적합을 줄이기 위해 학습할 때 확률적으로 일부 뉴런에 대한 연결을 끊어주는 드롭아웃(Dropout) 레이어(Hinton et al., 2012)를 추가해주었다. 이때 드롭아웃 확률은 다양한 확률로 실험해 본 후 가장 나은 결과를 보여준 20%로 설정하였다. 그 결과 Fig. 5에서와 같이 이번에도 학습 데이터(Training data)의 학습률은 빠르게 1에 도달하였다. 그러나 드롭아웃 레이어를 사용하기 전(Fig. 4)에 검정 손실이 1.5수준으로 점점 증가하며 과적합의 모습을 보여준 것에 반하여 드롭아웃 레이어를 추가해준 후(Fig. 5) 검정 손실이 0.8 수준에 꾸준히 머물면서 과적합되는 모습이 확연히 줄어들었으며 80회 정도의 에포크에서 검정 적합도가 91.7%까지 상승하는 결과를 보여주었다. 288장의 적은 수의 이미지 데이터로 생성한 인공지능 모델에서 기대 이상의 정확도를 보여주었으며, 이는 환경 컨트롤이 정밀하고 재배 식물의 생장 상태가 균일한 식물공장의 특성에 의해 이미지 데이터가 규격화되어 있기 때문으로 보인다. 이런 강점을 살린다면 앞으로 식물공장을 통한 빅데이터를 활용하여 다양한 인공지능 모델 연구에 사용할 수 있을 것으로 보인다.

티처블 머신(Teachable Machine)

티처블 머신에서도 합성곱 신경망(CNN)에서와 동일한 파라메터를 기준으로 가져와 학습시켰다(Table 1). 다만 GUI로 단순화되어있는 티쳐블머신의 특성으로 인하여 인공신경망의 은닉층의 구조를 변경할 수는 없었다.

Table 1.

Parameters for the convolutional neural network and the Google’s Teachable Machine

통계적 유의성을 위해 학습된 머신러닝 모델을 5번 생성하였으며 5번 생성한 인공지능 모델의 정식 후 생육 일수(DAT) 판별의 정확도를 검정하기 위해 학습에 사용되지 않은 48개의 이미지 표본을 5번 생성된 모델에 각각 대입하여 결과를 확인하였다(Fig. 6). 그 결과 측정된 240번의 검정에 따른 각각의 정식 후 일수(DAT)에 대한 예측확률과 예측일은 Fig. 7과 같았다. 정확한 정식 후 일수로 예측한 확률은 Fig. 7의 예상 확률(Estimated probability)과 같았고 그 평균은 82.3%였다. Fig. 7에서 낮은 확률로 보이는 샘플들은 정확한 정식 후 일수 대신 앞뒤 날짜로 예측하였다.

그 결과, 정확한 일자를 최대확률을 통해 예측한 경우가 208번으로 그 중 86.7%였다. 정식 후 일수를 한단계 더 빠른 시기로 예측한 경우가 15번으로 6.2%였으며, 한단계 더 늦은 시기로 예측한 경우가 17번으로 7.1%였다. 정식 후 일수를 두 단계 이상 잘못 예측한 경우는 존재하지 않았다.

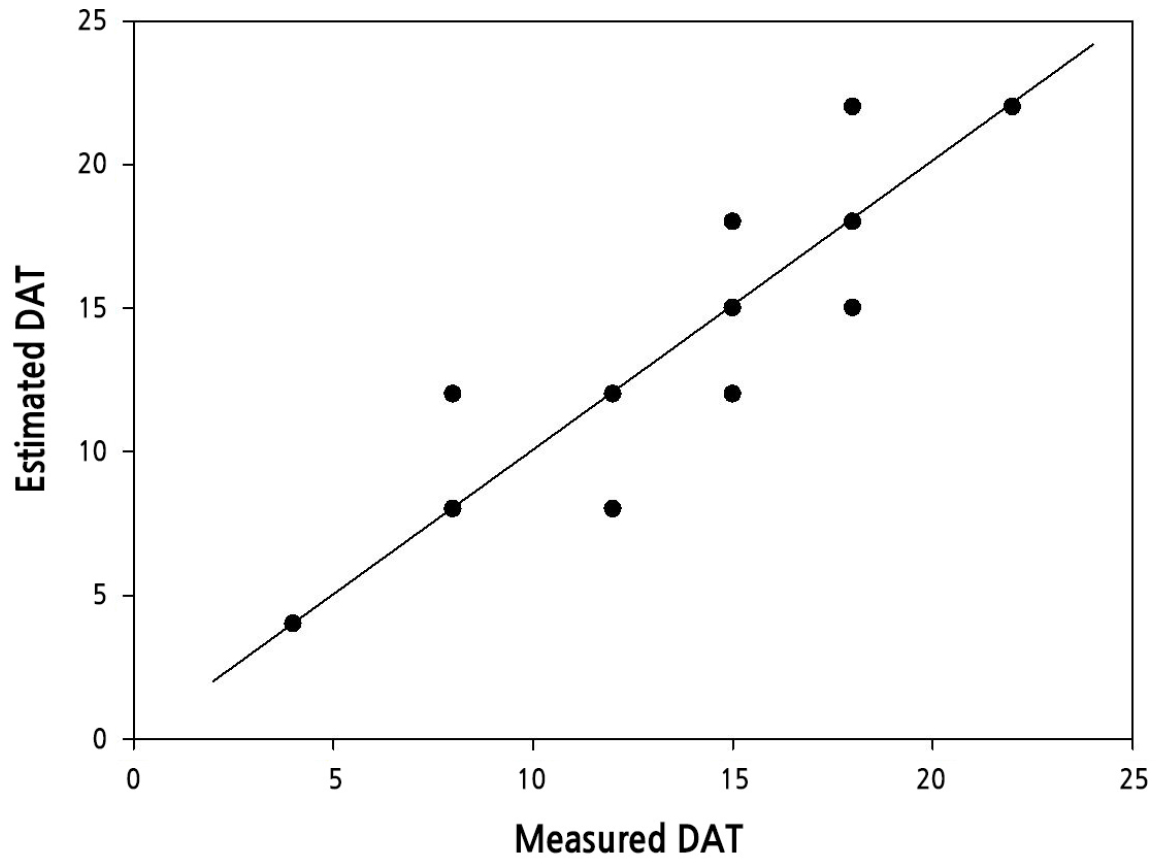

결과를 바탕으로 실재 정식 후 일수와 티처블 머신 모델에서 예측된 정식 후 일수와의 관계를 분포로 나타내어 회귀 분석하였고 결정계수 R2 = 0.96이었다(Fig. 8). 머신러닝 모델의 정식 후 생육 일자 판별에 유의한 결과를 보여주었으며 최대오차가 4일이었음을 감안할 때, 인공지능 초기 모델로서 추후 현장에 활용될 수 있는 가능성을 보여주었다고 생각된다.

합성곱 신경망과 티처블 머신 모두 데이터가 많아질수록 모델의 정확도가 상승하는 인공신경망의 특성으로 미루어 추가 실험들을 통해 더 많은 개체와 날짜에 대한 이미지 데이터를 확보하여 모델에 추가 학습시켜준다면 판별 구간을 더욱 세분화하고 정확도도 더욱 높일 수 있을 것으로 생각된다. 이를 통해 식물공장 재배 현장에 인공지능 이미지 판별을 도입하여 재배 식물의 생장을 실시간으로 확인하고 피드백 할 수 있는 시스템을 갖출 수 있을 것으로 생각된다.

또한 티처블 머신(Teachable Machine)이 합성곱 신경망을 통해 직접 코딩을 하는 것보다 은닉층을 최적화하는 설정이 부족한 것이 아쉬웠으나, GUI를 통해 손쉽게 접근하여 사용할 수 있는 장점이 있기에 프로그래밍에 익숙지 않은 사용자들도 머신러닝을 활용하여 농업에 응용하는데 도움이 될 수 있을 것으로 생각된다.